jornada.com.mx

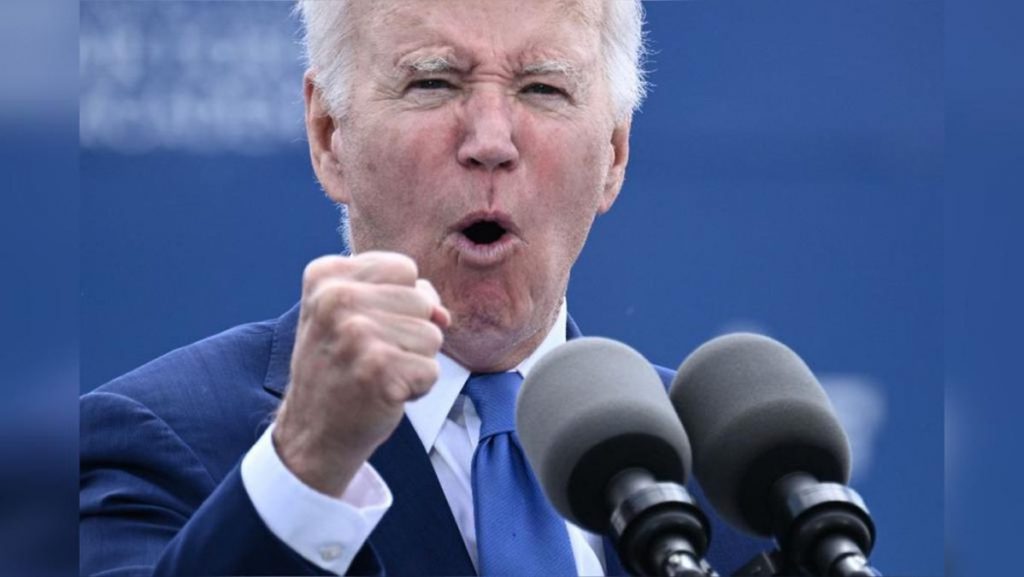

El presidente de Estados Unidos, Joe Biden, sumó la inteligencia artificial (IA) a las amenazas que enfrenta su país y afirmó que esta tecnología podría cambiar el carácter de los conflictos. Ayer ofreció un discurso en la ceremonia de graduación de alumnos de la Academia de la Fuerza Aérea, efectuada en Colorado Springs.

“No serán decisiones fáciles, chicos”, afirmó Biden al hacer alusión a la rápida transformación tecnológica. “Me reuní en la Oficina Oval con ocho líderes científicos especializados en IA. Algunos están muy preocupados de que esta tecnología pueda remplazar al pensamiento humano en el planeta. Así que tenemos mucho con lo que lidiar. Es una oportunidad increíble, pero hay mucho que discutir”.

El presidente estadunidense se reunió el 5 de mayo en la Casa Blanca con los responsables de las compañías de IA como Google, Microsoft y OpenAI para discutir reformas que aseguren que los productos de esta tecnología son seguros antes de ser lanzados al público.

La Casa Blanca ha anunciado diversas iniciativas para promover la innovación responsable en el campo. Destaca el lanzamiento de siete nuevos institutos nacionales para investigar la IA que serán financiados con 140 millones de dólares de la Fundación Nacional de Ciencia. La propuesta busca la cooperación entre las agencias federales, los desarrolladores del sector privado y la academia para perseguir un avance ético, confiable y responsable para que la IA sirva al bien público.

La iniciativa incluye una nueva guía de políticas sobre el uso de los sistemas de inteligencia artificial de la Oficina de Administración y Presupuesto para permitir comentarios públicos. Las políticas buscarán garantizar el desarrollo, la adquisición y el uso de sistemas de inteligencia artificial que se centren en salvaguardar los derechos y la seguridad de las personas.

Por otro lado, en Nueva York directivos de OpenAI, Google DeepMind, Anthropic y otros laboratorios de inteligencia artificial advierten que los sistemas del futuro podrían ser tan mortíferos como las pandemias y las armas nucleares.

Como publicó La Jornada el miércoles, un grupo de líderes de la industria advirtió el martes que esa tecnología algún día podría ser una amenaza para la humanidad y debería considerarse un peligro social. “Mitigar el riesgo de extinción de la inteligencia artificial debería ser una prioridad mundial junto a otros riesgos a escala social, como las pandemias y las guerras nucleares”, destaca la declaración publicada por el Centro para la Seguridad de la IA, una organización sin fines de lucro. La carta abierta está firmada por más de 350 ejecutivos, investigadores e ingenieros que trabajan en esa área.

Entre los firmantes figuran altos ejecutivos de tres de las principales empresas de inteligencia artificial: Sam Altman, director ejecutivo de OpenAI; Demis Hassabis, director ejecutivo de Google DeepMind, y Dario Amodei, director ejecutivo de Anthropic.

Geoffrey Hinton y Yoshua Bengio, dos de los tres investigadores galardonados con el Premio Turing por su trabajo pionero en redes neuronales y que a menudo son considerados los “padrinos” del movimiento moderno de la inteligencia artificial, firmaron la declaración, al igual que otros destacados investigadores de ese campo. (El tercer ganador del Premio Turing, Yann LeCun, quien dirige los esfuerzos de Meta para la investigación en IA, no había firmado hasta el martes).

La declaración llega en un momento de creciente preocupación por los posibles perjuicios de la inteligencia artificial. Los recientes avances en los llamados modelos grandes de lenguaje –el tipo de sistema utilizado por ChatGPT y otros chatbots– han suscitado el temor de que esa tecnología pueda utilizarse pronto a gran escala para difundir desinformación y propaganda, o eliminar millones de puestos de trabajo.

Temores de líderes de la industria

Algunos creen que, si no se hace nada para frenarla, podría llegar a ser tan poderosa como para provocar trastornos a escala social en unos pocos años, aunque los investigadores aún no explican cómo ocurriría eso.

Estos temores son compartidos por numerosos líderes de la industria, lo que los ubica en la inusual posición de argumentar que una tecnología que están desarrollando –y que, en muchos casos, se apresuran a construir más rápido que sus competidores– plantea graves riesgos y debería regularse de manera estricta.

Dan Hendrycks, director ejecutivo del Centro para la Seguridad de la IA, declaró en una entrevista que la carta abierta representaba una “salida del clóset” para algunos líderes del sector que habían expresado su preocupación –pero sólo en privado– por los riesgos de la tecnología que están desarrollando.

“Existe la idea errónea, incluso en la comunidad de la IA, de que sólo hay un grupo de catastrofistas”, indicó Hendrycks. “Pero, de hecho, muchas personas expresan en privado su preocupación por estas cosas”.

Algunos escépticos sostienen que la inteligencia artificial aún está en ciernes como para suponer una amenaza existencial. Respecto a los sistemas actuales, les preocupan más los problemas a corto plazo, como las respuestas sesgadas e incorrectas, que los peligros a largo plazo.

Otros argumentan que la IA avanza con tanta rapidez que ya ha superado el rendimiento humano en algunas áreas y que pronto lo hará en otras.